![]() Sinequa, l’éditeur leader de l’Enterprise Search, annonce l’intégration de Microsoft Azure OpenAI Service à ses capacités de recherche neuronale, permettant ainsi d’exploiter des connaissances d’entreprise de manière inédite en combinant une pertinence inégalée avec des synthèses pointues et une interface conversationnelle intuitive. Cette innovation, unique sur le marché, est conçue pour aider les utilisateurs à obtenir des informations, ainsi qu’à interagir avec elles de manière plus rapide et plus naturelle.

Sinequa, l’éditeur leader de l’Enterprise Search, annonce l’intégration de Microsoft Azure OpenAI Service à ses capacités de recherche neuronale, permettant ainsi d’exploiter des connaissances d’entreprise de manière inédite en combinant une pertinence inégalée avec des synthèses pointues et une interface conversationnelle intuitive. Cette innovation, unique sur le marché, est conçue pour aider les utilisateurs à obtenir des informations, ainsi qu’à interagir avec elles de manière plus rapide et plus naturelle.

La solution proposée par Sinequa introduit la puissance de l’intelligence artificielle générative dans l’entreprise en associant deux technologies puissantes : d’une part, la pertinence hors pair de la plateforme de recherche neuronale de Sinequa et, d’autre part, la capacité de synthèse et d’interactivité de l’IA générative. Cette combinaison est essentielle dans la mesure où elle constitue le seul moyen de libérer en toute sécurité la puissance des grands modèles de langage (LLM), basés sur l’IA générative.

« L’émergence rapide de la technologie ChatGPT au cours des derniers mois a amené les dirigeants d’entreprise à s’interroger quant aux possibilités d’utiliser les grands modèles de langage basés sur l’IA générative pour accélérer l’innovation et accroître la productivité », déclare Alexandre Bilger, co-CEO de Sinequa. « La combinaison de la précision et de la pertinence qui caractérise la technologie de recherche neuronale de Sinequa, de l’interface en langage naturel et des capacités de réponse de ChatGPT, permet de créer une synergie puissante encore inédite au sein de l’entreprise, grâce à laquelle les employés peuvent converser avec les contenus ».

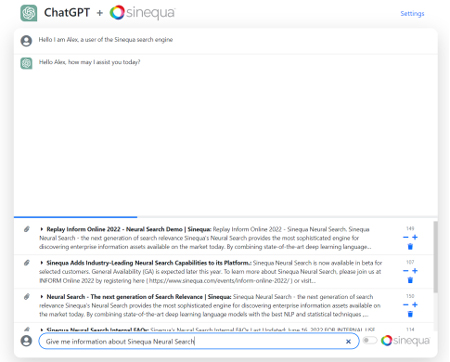

Les grands modèles de langage basés sur l’IA générative tels que ceux qui alimentent ChatGPT conviennent parfaitement aux fonctions de recherche, car ils enrichissent la manière dont les collaborateurs peuvent interagir, affiner et reformuler les résultats de leur recherche. Le modèle GPT de Sinequa synthétise les informations recueillies par le moteur de recherche neuronale de Sinequa dans des formats plus rapidement assimilables et réutilisables qui répondent aux besoins spécifiques de l’employé. Par ailleurs, le modèle GPT de Sinequa permet d’établir un dialogue interactif, de sorte que les utilisateurs peuvent approfondir leurs questions, mais également affiner la recherche ou la réponse proposée. Ainsi, les utilisateurs peuvent converser avec leurs contenus et dialoguer avec leurs données, le tout en utilisant le langage naturel.

À titre d’exemple, les chercheurs et les ingénieurs qui posent des questions complexes et attendent des réponses peuvent extraire des passages d’articles pertinents en utilisant la fonction de recherche neuronale de Sinequa. Pour ensuite compléter le résultat avec l’aide de ChatGPT afin de créer un résumé ciblé de leur recherche et ainsi réaliser une présentation rapide, pratique et complète de leurs informations.

« En associant les puissantes capacités de recherche neuronale de Sinequa à des modèles de langage basés sur l’IA générative, l’offre ChatGPT de Sinequa fournit des réponses précises, rapides, exploitables et traçables au sein d’un environnement d’entreprise parfaitement sécurisé », ajoute Alexandre Bilger. « Au bout du compte, la recherche contribue à accroître l’efficacité des entreprises en capitalisant sur les contenus disponibles, tandis que la combinaison de ces données et de grands modèles de langage basés sur l’IA générative augmente la valeur de l’Enterprise Search en accélérant et en simplifiant l’accès aux informations nécessaires pour accroître la productivité et favoriser l’innovation. »