Si l’avènement de la 5G est encore loin, la 6G est déjà en marche. En effet, le temps nécessaire au développement d’une nouvelle génération de réseau sans-fil implique que les travaux sur la 6G aient déjà commencé, depuis quelques années déjà.

Si l’avènement de la 5G est encore loin, la 6G est déjà en marche. En effet, le temps nécessaire au développement d’une nouvelle génération de réseau sans-fil implique que les travaux sur la 6G aient déjà commencé, depuis quelques années déjà.

Les premiers travaux sur la 5G ont préparé le terrain pour le développement d’une technologie basée sur une vision centrée sur l’utilisateur ; la 6G suit cet exemple. Les livres blancs de l’UIT, de Samsung, de Docomo et de l’université d’Oulu décrivent des cas d’utilisation et des spécificités de réseau futuristes : communications holographiques tactiles, jumeaux numériques précis, IoT industriel dans le cloud, IoT social ou sociétal et une utilisation généralisée de l’IA pour coupler les communications et l’informatique avec la société, etc. Les indicateurs de performance (KPI) traditionnels comprennent des débits de données de 1 Tbps, une mobilité de 1 000 km/h et une latence de 0,1 ms. Les nouveaux KPI comprendront la précision et l’exactitude du timing (communications "à temps" et "à l’heure") et la capacité de localiser un lieu au centimètre près.

Quel sera l’impact de la 6G sur la conception, les tests et la mesure des appareils électroniques ? Les retours d’expériences des 5 précédentes générations nous permettent d’anticiper les 3 points suivants :

Quel sera l’impact de la 6G sur la conception, les tests et la mesure des appareils électroniques ? Les retours d’expériences des 5 précédentes générations nous permettent d’anticiper les 3 points suivants :

![]() Les tests auront lieu dans les domaines historiques et nouveaux ;

Les tests auront lieu dans les domaines historiques et nouveaux ;

![]() La technologie et les solutions de test évolueront au fil du temps ;

La technologie et les solutions de test évolueront au fil du temps ;

![]() La validation complexe au niveau du système dans son ensemble jouera un rôle encore plus important que dans les générations précédentes.

La validation complexe au niveau du système dans son ensemble jouera un rôle encore plus important que dans les générations précédentes.

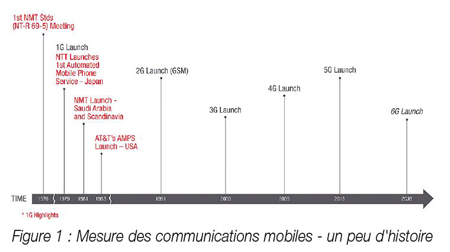

Mais l’arrivée de la 6G prendra un certain temps. Les systèmes radio mobiles automatisés ceux qui ne nécessitent pas d’opérateur ou de fonction "push-to-talk" ont été conçus au début des années 70, en s’appuyant sur le concept de réutilisation des fréquences, breveté par Bell Labs à la fin des années 40. NTT a lancé son premier système commercial en 1979, suivi par les lancements saoudien et nordique de NMT en 1981, puis par le lancement de l’AMPS par AT&T aux États-Unis en 1983. Chaque génération a été lancée à une décennie d’intervalle (voir figure 1).

La technologie mobile nous a d’abord permis d’emporter nos téléphones partout, cela est désormais possible pour tout ce qui touche au travail, à l’école ou aux divertissements. Si les générations précédentes sont considérées comme acquises, il faut rappeler que la 1G n’était pas réalisable sans microprocesseur, la 2G et la 3G ont révolutionné les émetteurs-récepteurs radio numériques, et la 4G n’existerait pas sans la batterie lithium-ion. La 6G doit devenir partie intégrante de la société.

Et l’industrie exerce une pression constante sur le progrès, en recherchant et développant des technologies à prix abordable.

Cette pression dicte également l’évolution des critères de test et de mesure, d’abord concentrés sur la mesure de la radiophysique : puissance, sensibilité et problèmes d’interférence, puis sur deux axes :

![]() La manière dont ces mesures devaient être effectuées ;

La manière dont ces mesures devaient être effectuées ;

![]() L’exigence sur la validation, avec des niveaux toujours plus élevés de performance des systèmes.

L’exigence sur la validation, avec des niveaux toujours plus élevés de performance des systèmes.

Les mesures de sensibilité basées sur le rapport signal/bruit ont évolué vers un taux d’erreur sur les bits (BER) puis vers un taux d’erreur sur les blocs (BLER), et doivent maintenant prendre en compte le bruit en plus de l’interférence. La précision de la modulation est passée de l’erreur de profondeur de modulation à l’amplitude du vecteur d’erreur (EVM). Après le test des codecs vocaux, du débit de données, de la consommation de batterie et des transferts, nous mesurons des aspects tels que l’efficacité des programmateurs et même la qualité de service (QoS).

La 5G soulève des questions relatives aux exigences de sécurité, fiabilité, latence et de consommation d’énergie. Les demandes croissantes de l’industrie et de la société exigent que la simulation, la conception, la mesure et la validation passent de mesures purement physiques aux performances de voix et de données, puis aux performances système.

La société est particulièrement attentive à l’arrivée de la 5G et s’intéresse plus spécialement à la protection du public, à la sécurité de l’information et aux intérêts nationaux. Cela se traduit par des exigences dans la conception et la validation, non seulement pour les nouveaux éléments matériels comme la précision temporelle et la gigue mais aussi pour les éléments du système, notamment le respect des accords de niveau de service (SLA) et la qualité de l’expérience (QoE).

Pour la 6G, ces exigences concernant les performances du système seront également liées à la réglementation. Si les gouvernements disposent d’une tranche de réseau 6G, et si la 6G s’intègre à la conduite autonome ou la santé connectée, il faudra impérativement respecter les strictes exigences en matière de sécurité et de fiabilité, car les citoyens ne toléreront aucun manquement de la part des gouvernements et des industriels.

Ainsi la 6G entraînera de nouvelles exigences techniques dans cinq grands domaines :

![]() La prochaine génération de radio dans toutes les bandes, en plus de l’ajout de bandes au-dessus de 100 GHz prévoit une nouvelle technologie pour améliorer le rendement spectral et énergétique <8 GHz, des évolutions dans les ondes millimétriques 20-70 GHz et l’ajout de sous-fréquences (100-1000 GHz) pour les communications, la détection et l’imagerie ;

La prochaine génération de radio dans toutes les bandes, en plus de l’ajout de bandes au-dessus de 100 GHz prévoit une nouvelle technologie pour améliorer le rendement spectral et énergétique <8 GHz, des évolutions dans les ondes millimétriques 20-70 GHz et l’ajout de sous-fréquences (100-1000 GHz) pour les communications, la détection et l’imagerie ;

![]() La technologie d’accès multi-radio (RAT) intégrée et hétérogène : avec un usage fluide et intelligent des systèmes radio 6G dans des réseaux non terrestres ainsi que des systèmes sans fil existants, des réseaux domestiques et NFC ;

La technologie d’accès multi-radio (RAT) intégrée et hétérogène : avec un usage fluide et intelligent des systèmes radio 6G dans des réseaux non terrestres ainsi que des systèmes sans fil existants, des réseaux domestiques et NFC ;

![]() Ingénierie temporelle dans les réseaux : réduction de la durée de réponse, et ajout d’une latence prévisible et programmable pour des applications en temps réel.

Ingénierie temporelle dans les réseaux : réduction de la durée de réponse, et ajout d’une latence prévisible et programmable pour des applications en temps réel.

![]() Réseaux avec IA : utilisation de l’intelligence artificielle pour optimiser le fonctionnement et les performances des réseaux en temps réel, ainsi que la connectivité et le partage autonome de données, de modèles et de connaissances grâce à l’IA ;

Réseaux avec IA : utilisation de l’intelligence artificielle pour optimiser le fonctionnement et les performances des réseaux en temps réel, ainsi que la connectivité et le partage autonome de données, de modèles et de connaissances grâce à l’IA ;

![]() Sécurité avancée : application généralisée des technologies de sécurité pour la protection de la vie privée, la prévention, la détection et la résilience aux attaques ainsi que la récupération des données dans un environnement informatique corrompu.

Sécurité avancée : application généralisée des technologies de sécurité pour la protection de la vie privée, la prévention, la détection et la résilience aux attaques ainsi que la récupération des données dans un environnement informatique corrompu.

Tous ces champs, sauf le premier, devront être validés au niveau radiophysique pour le système global. Les prédictions selon lesquelles certains tests au niveau du système seront dictés par des exigences politiques sont parfois rejetées mais force est de constater que les gouvernements du monde entier sont engagés à s’entendre concernant le déploiement de la 5G, sur la sécurité des réseaux et les intérêts nationaux. Les autorités locales pensent des directives relatives à l’utilisation des appareils mobiles, à l’emplacement des antennes mobiles et à l’exposition aux ondes électromagnétiques. En outre, les ministères de la Défense se sont emparés de la 5G, bien plus tôt que pour les technologies précédentes, et explorent déjà son utilisation pour leurs besoins spécifiques.

Beaucoup de questions se posent alors pour les industriels : Comment valider ce qui est fourni dans mon SLA ? Quelle est la cause des problèmes de qualité de la voix ? Comment garantir que les jeux mobiles fonctionnent correctement sur le réseau et sur des appareils mobiles spécifiques ? Quel niveau de sécurité peut-on garantir ?

Et si vous avez encore des doutes quant à l’impact de la réglementation, pensez aux débuts de la radio : l’appel universel de détresse : S-O-S (en morse ...---...) n’a pas toujours été la norme. Ces trois symboles, choisis pour leur simplicité et leur facilité de distinction, ont été normalisés lors de la Convention Radiotélégraphique Internationale de Berlin en 1906. La catastrophe du Titanic en 1912 a conduit à la généralisation non seulement d’un canal radio de détresse commun (500KHz (λ=600m)), mais aussi du droit maritime international qui indique que tous les bureaux radiotélégraphiques de bord doivent être pourvus en personnel à tout moment. Ainsi, nous avons déjà une première ébauche de principe qui dicte 1) les types de messages, 2) les canaux radio et 3) le comportement. Depuis lors, il existe de nombreux autres exemples et, les systèmes radio étant un élément fondamental de la société, nous pouvons nous attendre à en voir d’autres émerger avec l’avènement de la 5G, et de la 6G après elle.